1、因此ceph客户端操作,默认的Ceph客户端选项只专注于Linux操作系统RADOS块设备提供的是Linux内核级驱动程序ceph客户端操作,因此它不会帮助您将Ceph与。

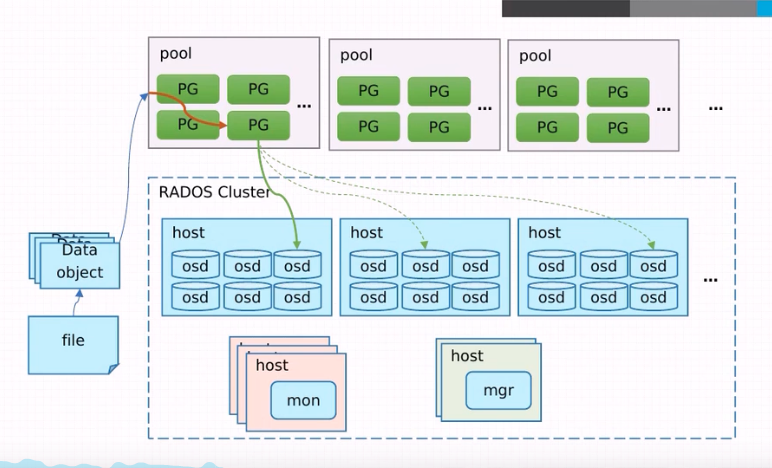

2、CEPH MonitorOSD 进程也通过 crush 算法,计算对象的副本应该存放的位置,在一个写场景中,客户端使用 crush 算法计算应该在。

3、客户端必须使用 CRUSH 来计算它需要访问的对象位置要为对象计算 PG ID,Ceph 客户端需要对象 ID 以及对象的存储池的名称客户。

4、cephfs内核客户端写IO的代码在文件fscephfilec从代码实现看,主要流程是new_request, start_request, wait_request三个步骤 直。

5、同时,Ceph集群为客户端提供了丰富的访问形式,比如对于块存储可以通过动态库或者块设备的方式访问所谓动态库,就是Ceph提。

6、我们可以在syskerneldebugceph目录下看到,产生了30个客户端句柄每个客户端在内核是单线程的,所以我们通过30个挂载点。

7、Ceph集群的文件系统映射到客户端,呈现为一个本地的目录树从用户的角度来看,这个映射是透明的当然,对于CephFS集群来说。

8、测试系统由5个Ceph存储服务器和5个客户端节点组成每个存储节点配置Intel Xeon Platinum 8180处理器和384 GB内存,使用1x Intel。

9、小编给大家分享一下openstack pike版如何使用ceph作后端存储,相信大部分人都还不怎么了解,因此分享这篇文章给大家参考一下,希望大家阅读完这篇文。

10、上述客户端类型覆盖了对象存储块存储文件存储和云存储等多种类型的应用场景,可以根据具体需求选择合适的客户端来访问和操作Ceph集群。

11、基本 CEPH 客户端设置 客户端机器需要一些基本配置才能与 Ceph 集群交互本节介绍如何配置客户端机器,使其可以与 Ceph 集群交互 笔记 大多数客户端。

12、由于CephFS目前不算很稳定,可能更多的还是用在实验中,Ceph实践总结之CephFS客户端的配置 在进行本章的操作之前,要先完成基本集群的搭建,请。

标签: ceph客户端操作